konkret: Ich habe zur Black Week folgenden Server bei Hetzner bestellt: Den AX 101.

Diese Ausstattung habe ich dabei gewählt:

- 2 im Angebot enthaltene NVME Disks mit jeweils 3,84 TB Speicher

- 4 SATA Festplatten mit je 1 TB Speicher.

- 1 * 16 GB USB Stick

Das Angebot insgesamt ist ja eindeutig formuliert und gerne genommen.

Hohe Rechenleistung und schneller sowie grosser SSD Speicherbereich neben einer sehr guten Möglichkeit der Erweiterung. Preis Leistung jedenfalls top!

Mein Einsatzzweck ist das Ablösen mehrere alter Webserver mit Shoplösungen auf wenige leistungsfähige Systeme. Liebäugeln tu ich schon länger mit dem System, die hohen Einrichtungskosten waren mir aber bisher zu hoch. Zu gut kann ich mich daran erinnern, dass so manche Hardwarekombination und der Einsatz von openSUSE Probleme bereiteten. Somit kam der Black Friday gerade recht, um der Hardware eine Chance zu geben und dies ausgiebig zu testen. Und damit komme ich um unangenehme Einrichtungskosten herum, wenn es nicht klappt mit dem System.

Aufbau des Systems

Folgende Überlegung stand zu Grunde:

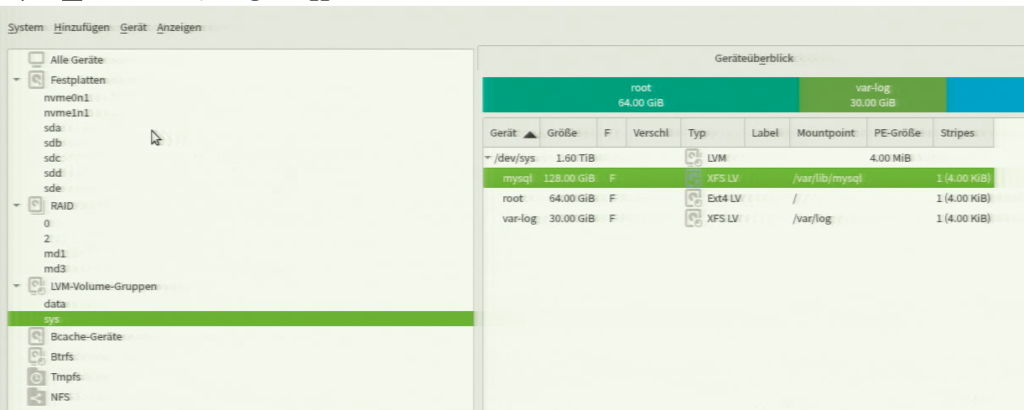

Ich möchte mehrere Dienste auf einen Knoten zusammen führen. Datenbanken, MySQL und PostgreSQL, Webapplikationen und Cachesysteme.

Somit ergab sich folgende Überlegung:

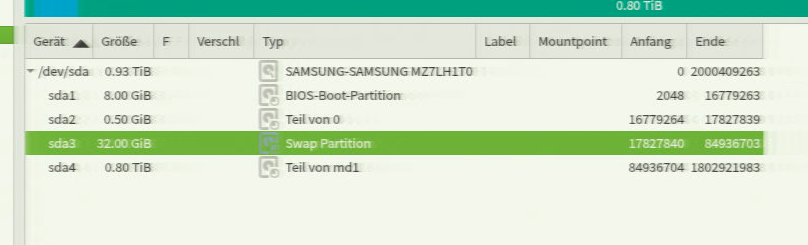

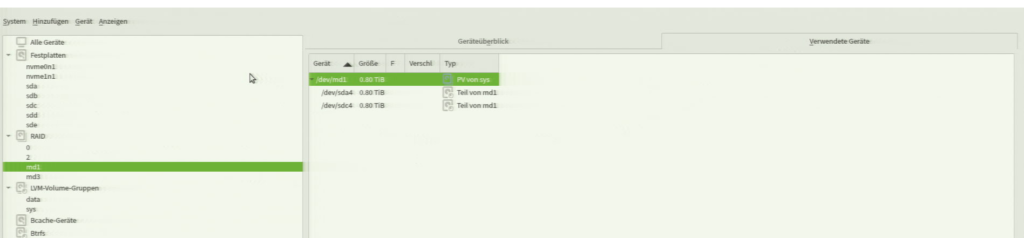

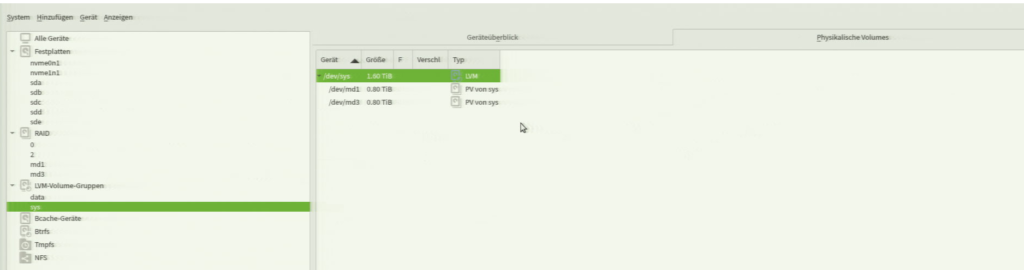

- Aus den 4 SATA Platten erstelle ich ein Raid10

- Nutzung für das Betriebsystem und die Datenbanken damit eine hohe IO Last keine Auswirkung auf die Webapplikation hat und umgekehrt.

- Die beiden NVME Disks fasse ich in ein Raid 1 zusammen.

- Um später flexibler konfigurieren zu können, wird jedes Raid über LVM verwaltet Logical Volume: sys (Raid 10) und data (Raid 1).

Beim 1. Anlauf das System zu installieren stiess ich auf folgende Auffälligkeiten:

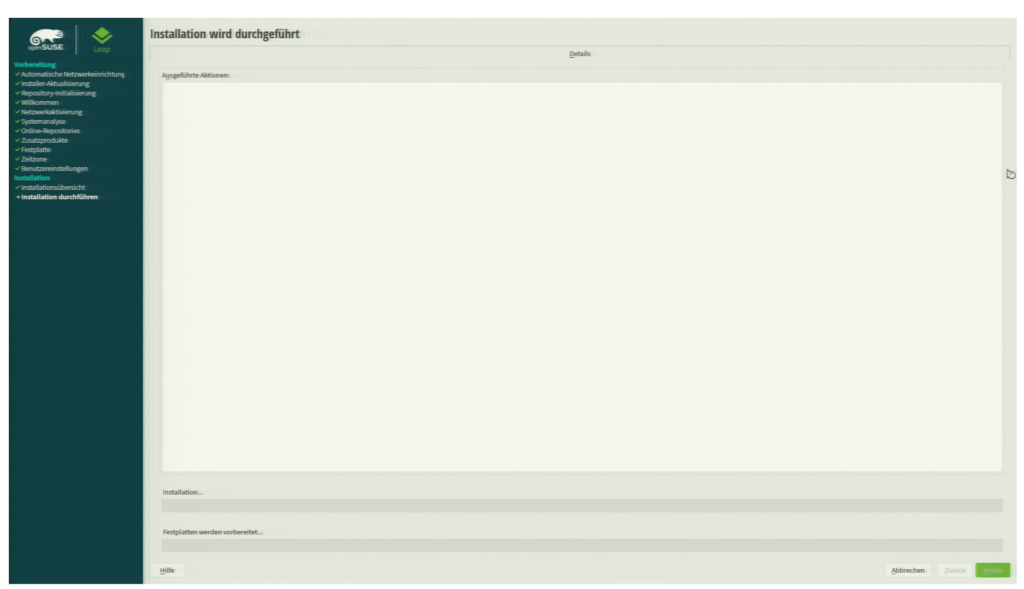

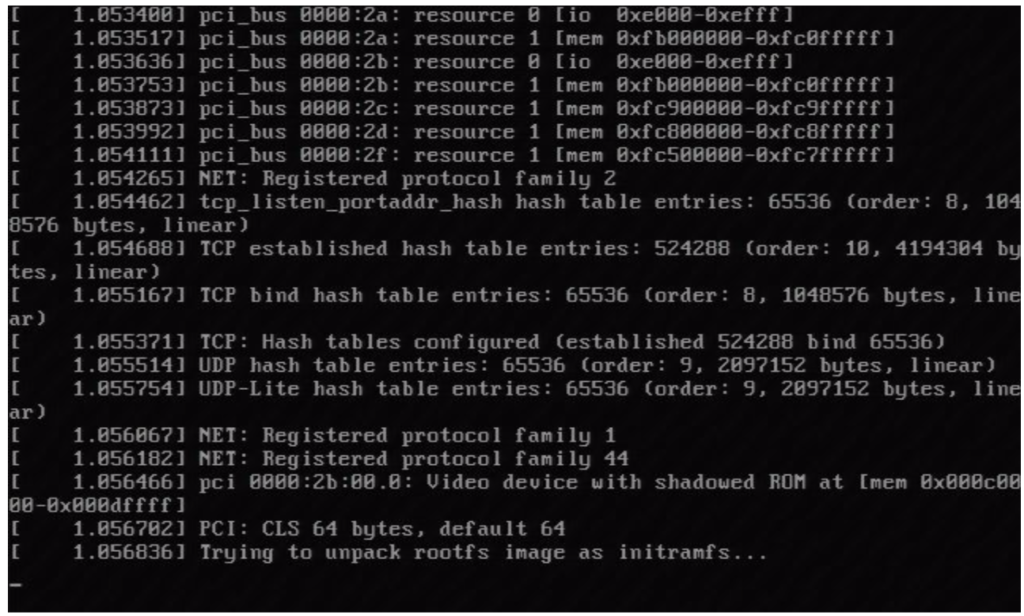

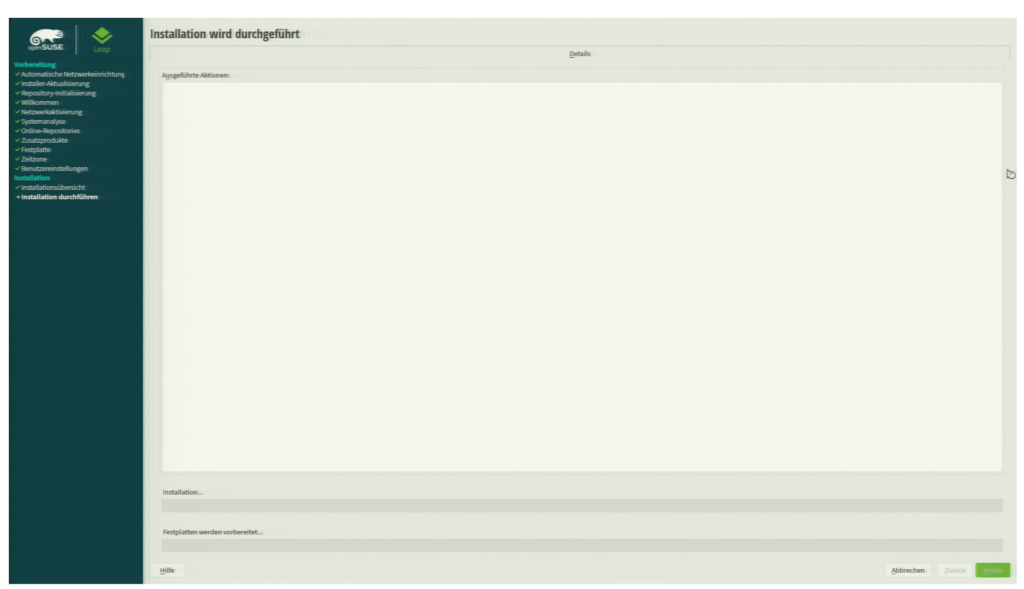

Installation erfolgte über ein aktuelles Installation ISO von openSUSE 15.3. Am Ende des Installationsprozesses bzw. an dem Schritt, wenn alle Einstellungen vorgenommen wurden, startet das Einrichten der Festplatten…. und dies dauerte ewig. Ich dachte zunächst, ds System sei eingefroren. Nachdem dann die KVM Lösung wieder entfernt wurde …. ging ich zunächst ins Bett. Es war dann spät geworden. Wollte es am nächsten Morgen nochmals an gehen. Zu meiner Überraschung, das System war online und die Installation durchgelaufen.

Der Benchmark verlief wie erwartet.

Das Ergebnis aus den SATA iops Benchmark: /dev/sda, 1.02 T, sectorsize=512B, #threads=10, pattern=random: 512 B blocks: 99045.3 IO/s, 50.7 MB/s (405.7 Mbit/s) 1 kB blocks: 70631.5 IO/s, 72.3 MB/s (578.6 Mbit/s) 2 kB blocks: 45433.2 IO/s, 93.0 MB/s (744.4 Mbit/s) 4 kB blocks: 26687.1 IO/s, 109.3 MB/s (874.5 Mbit/s) 8 kB blocks: 15775.7 IO/s, 129.2 MB/s ( 1.0 Gbit/s) 16 kB blocks: 8612.9 IO/s, 141.1 MB/s ( 1.1 Gbit/s) 32 kB blocks: 8071.4 IO/s, 264.5 MB/s ( 2.1 Gbit/s) 65 kB blocks: 4098.7 IO/s, 268.6 MB/s ( 2.1 Gbit/s) 131 kB blocks: 1978.8 IO/s, 259.4 MB/s ( 2.1 Gbit/s) 262 kB blocks: 998.6 IO/s, 261.8 MB/s ( 2.1 Gbit/s) 524 kB blocks: 546.7 IO/s, 286.6 MB/s ( 2.3 Gbit/s) 1 MB blocks: 353.0 IO/s, 370.1 MB/s ( 3.0 Gbit/s) 2 MB blocks: 183.1 IO/s, 384.0 MB/s ( 3.1 Gbit/s) 4 MB blocks: 117.9 IO/s, 494.3 MB/s ( 4.0 Gbit/s) 8 MB blocks: 65.0 IO/s, 545.5 MB/s ( 4.4 Gbit/s) 16 MB blocks: 34.7 IO/s, 581.7 MB/s ( 4.7 Gbit/s) 33 MB blocks: 18.1 IO/s, 608.6 MB/s ( 4.9 Gbit/s) 67 MB blocks: 9.4 IO/s, 631.5 MB/s ( 5.1 Gbit/s) 134 MB blocks: 4.7 IO/s, 624.5 MB/s ( 5.0 Gbit/s) 268 MB blocks: 2.4 IO/s, 651.1 MB/s ( 5.2 Gbit/s) 536 MB blocks: 1.2 IO/s, 665.4 MB/s ( 5.3 Gbit/s) /dev/sdb, 1.02 T, sectorsize=512B, #threads=10, pattern=random: 512 B blocks: 99150.6 IO/s, 50.8 MB/s (406.1 Mbit/s) 1 kB blocks: 70480.8 IO/s, 72.2 MB/s (577.4 Mbit/s) 2 kB blocks: 45492.5 IO/s, 93.2 MB/s (745.3 Mbit/s) 4 kB blocks: 26684.7 IO/s, 109.3 MB/s (874.4 Mbit/s) 8 kB blocks: 15788.2 IO/s, 129.3 MB/s ( 1.0 Gbit/s) 16 kB blocks: 8619.8 IO/s, 141.2 MB/s ( 1.1 Gbit/s) 32 kB blocks: 8059.2 IO/s, 264.1 MB/s ( 2.1 Gbit/s) 65 kB blocks: 4095.0 IO/s, 268.4 MB/s ( 2.1 Gbit/s) 131 kB blocks: 1974.2 IO/s, 258.8 MB/s ( 2.1 Gbit/s) 262 kB blocks: 990.7 IO/s, 259.7 MB/s ( 2.1 Gbit/s) 524 kB blocks: 545.8 IO/s, 286.2 MB/s ( 2.3 Gbit/s) 1 MB blocks: 352.2 IO/s, 369.3 MB/s ( 3.0 Gbit/s) 2 MB blocks: 183.0 IO/s, 383.8 MB/s ( 3.1 Gbit/s) 4 MB blocks: 117.4 IO/s, 492.3 MB/s ( 3.9 Gbit/s) 8 MB blocks: 65.5 IO/s, 549.6 MB/s ( 4.4 Gbit/s) 16 MB blocks: 35.4 IO/s, 593.2 MB/s ( 4.7 Gbit/s) 33 MB blocks: 18.0 IO/s, 604.4 MB/s ( 4.8 Gbit/s) 67 MB blocks: 9.3 IO/s, 624.8 MB/s ( 5.0 Gbit/s) 134 MB blocks: 4.8 IO/s, 641.3 MB/s ( 5.1 Gbit/s) 268 MB blocks: 2.3 IO/s, 620.7 MB/s ( 5.0 Gbit/s) 536 MB blocks: 1.1 IO/s, 610.9 MB/s ( 4.9 Gbit/s) /dev/sdd, 1.02 T, sectorsize=512B, #threads=10, pattern=random: 512 B blocks: 99566.7 IO/s, 51.0 MB/s (407.8 Mbit/s) 1 kB blocks: 70651.5 IO/s, 72.3 MB/s (578.8 Mbit/s) 2 kB blocks: 45352.2 IO/s, 92.9 MB/s (743.0 Mbit/s) 4 kB blocks: 26648.9 IO/s, 109.2 MB/s (873.2 Mbit/s) 8 kB blocks: 15692.3 IO/s, 128.6 MB/s ( 1.0 Gbit/s) 16 kB blocks: 8578.4 IO/s, 140.5 MB/s ( 1.1 Gbit/s) 32 kB blocks: 8180.7 IO/s, 268.1 MB/s ( 2.1 Gbit/s) 65 kB blocks: 4306.7 IO/s, 282.2 MB/s ( 2.3 Gbit/s) 131 kB blocks: 2207.1 IO/s, 289.3 MB/s ( 2.3 Gbit/s) 262 kB blocks: 1132.0 IO/s, 296.8 MB/s ( 2.4 Gbit/s) 524 kB blocks: 583.2 IO/s, 305.8 MB/s ( 2.4 Gbit/s) 1 MB blocks: 381.2 IO/s, 399.7 MB/s ( 3.2 Gbit/s) 2 MB blocks: 169.5 IO/s, 355.6 MB/s ( 2.8 Gbit/s) 4 MB blocks: 100.6 IO/s, 422.0 MB/s ( 3.4 Gbit/s) 8 MB blocks: 59.8 IO/s, 501.5 MB/s ( 4.0 Gbit/s) 16 MB blocks: 32.2 IO/s, 539.9 MB/s ( 4.3 Gbit/s) 33 MB blocks: 16.7 IO/s, 560.0 MB/s ( 4.5 Gbit/s) 67 MB blocks: 8.4 IO/s, 564.8 MB/s ( 4.5 Gbit/s) 134 MB blocks: 4.3 IO/s, 577.5 MB/s ( 4.6 Gbit/s) 268 MB blocks: 2.2 IO/s, 582.5 MB/s ( 4.7 Gbit/s) 536 MB blocks: 1.2 IO/s, 656.1 MB/s ( 5.2 Gbit/s) /dev/sde, 1.02 T, sectorsize=512B, #threads=10, pattern=random: 512 B blocks: 99194.5 IO/s, 50.8 MB/s (406.3 Mbit/s) 1 kB blocks: 71068.3 IO/s, 72.8 MB/s (582.2 Mbit/s) 2 kB blocks: 45546.3 IO/s, 93.3 MB/s (746.2 Mbit/s) 4 kB blocks: 26681.9 IO/s, 109.3 MB/s (874.3 Mbit/s) 8 kB blocks: 15747.0 IO/s, 129.0 MB/s ( 1.0 Gbit/s) 16 kB blocks: 8619.8 IO/s, 141.2 MB/s ( 1.1 Gbit/s) 32 kB blocks: 8091.8 IO/s, 265.2 MB/s ( 2.1 Gbit/s) 65 kB blocks: 4106.8 IO/s, 269.1 MB/s ( 2.2 Gbit/s) 131 kB blocks: 1979.0 IO/s, 259.4 MB/s ( 2.1 Gbit/s) 262 kB blocks: 1006.8 IO/s, 263.9 MB/s ( 2.1 Gbit/s) 524 kB blocks: 550.3 IO/s, 288.5 MB/s ( 2.3 Gbit/s) 1 MB blocks: 355.3 IO/s, 372.6 MB/s ( 3.0 Gbit/s) 2 MB blocks: 177.1 IO/s, 371.4 MB/s ( 3.0 Gbit/s) 4 MB blocks: 102.4 IO/s, 429.3 MB/s ( 3.4 Gbit/s) 8 MB blocks: 60.0 IO/s, 503.2 MB/s ( 4.0 Gbit/s) 16 MB blocks: 32.0 IO/s, 537.5 MB/s ( 4.3 Gbit/s) 33 MB blocks: 16.6 IO/s, 557.7 MB/s ( 4.5 Gbit/s) 67 MB blocks: 8.4 IO/s, 567.0 MB/s ( 4.5 Gbit/s) 134 MB blocks: 4.3 IO/s, 578.4 MB/s ( 4.6 Gbit/s) 268 MB blocks: 2.1 IO/s, 571.4 MB/s ( 4.6 Gbit/s) 536 MB blocks: 1.1 IO/s, 571.9 MB/s ( 4.6 Gbit/s) Der gleiche Test auf das Raid 10 Device: /dev/md1, 1.76 T, sectorsize=512B, #threads=10, pattern=random: 512 B blocks: 130855.8 IO/s, 67.0 MB/s (536.0 Mbit/s) 1 kB blocks: 114133.3 IO/s, 116.9 MB/s (935.0 Mbit/s) 2 kB blocks: 90477.8 IO/s, 185.3 MB/s ( 1.5 Gbit/s) 4 kB blocks: 61635.4 IO/s, 252.5 MB/s ( 2.0 Gbit/s) 8 kB blocks: 42973.7 IO/s, 352.0 MB/s ( 2.8 Gbit/s) 16 kB blocks: 26979.0 IO/s, 442.0 MB/s ( 3.5 Gbit/s) 32 kB blocks: 25585.8 IO/s, 838.4 MB/s ( 6.7 Gbit/s) 65 kB blocks: 14934.4 IO/s, 978.7 MB/s ( 7.8 Gbit/s) 131 kB blocks: 8127.9 IO/s, 1.1 GB/s ( 8.5 Gbit/s) 262 kB blocks: 4341.5 IO/s, 1.1 GB/s ( 9.1 Gbit/s) 524 kB blocks: 2340.7 IO/s, 1.2 GB/s ( 9.8 Gbit/s) 1 MB blocks: 1533.0 IO/s, 1.6 GB/s ( 12.9 Gbit/s) 2 MB blocks: 690.3 IO/s, 1.4 GB/s ( 11.6 Gbit/s) 4 MB blocks: 411.0 IO/s, 1.7 GB/s ( 13.8 Gbit/s) 8 MB blocks: 241.9 IO/s, 2.0 GB/s ( 16.2 Gbit/s) 16 MB blocks: 129.8 IO/s, 2.2 GB/s ( 17.4 Gbit/s) 33 MB blocks: 66.8 IO/s, 2.2 GB/s ( 17.9 Gbit/s) 67 MB blocks: 31.5 IO/s, 2.1 GB/s ( 16.9 Gbit/s) 134 MB blocks: 15.1 IO/s, 2.0 GB/s ( 16.2 Gbit/s) 268 MB blocks: 8.1 IO/s, 2.2 GB/s ( 17.5 Gbit/s) 536 MB blocks: 4.2 IO/s, 2.3 GB/s ( 18.2 Gbit/s) 1 GB blocks: 2.3 IO/s, 2.4 GB/s ( 19.6 Gbit/s) 2 GB blocks: 1.1 IO/s, 2.4 GB/s ( 19.4 Gbit/s) Die beiden NVME Disks: /dev/nvme0n1, 3.84 T, sectorsize=512B, #threads=10, pattern=random: 512 B blocks: 131531.3 IO/s, 67.3 MB/s (538.8 Mbit/s) 1 kB blocks: 138440.1 IO/s, 141.8 MB/s ( 1.1 Gbit/s) 2 kB blocks: 167768.9 IO/s, 343.6 MB/s ( 2.7 Gbit/s) 4 kB blocks: 138710.8 IO/s, 568.2 MB/s ( 4.5 Gbit/s) 8 kB blocks: 102895.5 IO/s, 842.9 MB/s ( 6.7 Gbit/s) 16 kB blocks: 55574.6 IO/s, 910.5 MB/s ( 7.3 Gbit/s) 32 kB blocks: 52914.6 IO/s, 1.7 GB/s ( 13.9 Gbit/s) 65 kB blocks: 27175.7 IO/s, 1.8 GB/s ( 14.2 Gbit/s) 131 kB blocks: 13744.7 IO/s, 1.8 GB/s ( 14.4 Gbit/s) 262 kB blocks: 6997.9 IO/s, 1.8 GB/s ( 14.7 Gbit/s) 524 kB blocks: 3705.5 IO/s, 1.9 GB/s ( 15.5 Gbit/s) 1 MB blocks: 2310.9 IO/s, 2.4 GB/s ( 19.4 Gbit/s) 2 MB blocks: 1392.3 IO/s, 2.9 GB/s ( 23.4 Gbit/s) 4 MB blocks: 776.2 IO/s, 3.3 GB/s ( 26.0 Gbit/s) 8 MB blocks: 412.4 IO/s, 3.5 GB/s ( 27.7 Gbit/s) 16 MB blocks: 211.1 IO/s, 3.5 GB/s ( 28.3 Gbit/s) 33 MB blocks: 107.3 IO/s, 3.6 GB/s ( 28.8 Gbit/s) 67 MB blocks: 54.3 IO/s, 3.6 GB/s ( 29.2 Gbit/s) 134 MB blocks: 27.8 IO/s, 3.7 GB/s ( 29.9 Gbit/s) 268 MB blocks: 13.6 IO/s, 3.7 GB/s ( 29.2 Gbit/s) 536 MB blocks: 6.9 IO/s, 3.7 GB/s ( 29.5 Gbit/s) 1 GB blocks: 3.4 IO/s, 3.6 GB/s ( 28.9 Gbit/s) 2 GB blocks: 1.6 IO/s, 3.5 GB/s ( 27.7 Gbit/s) /dev/nvme1n1, 3.84 T, sectorsize=512B, #threads=10, pattern=random: 512 B blocks: 144943.4 IO/s, 74.2 MB/s (593.7 Mbit/s) 1 kB blocks: 127359.1 IO/s, 130.4 MB/s ( 1.0 Gbit/s) 2 kB blocks: 149276.5 IO/s, 305.7 MB/s ( 2.4 Gbit/s) 4 kB blocks: 135347.9 IO/s, 554.4 MB/s ( 4.4 Gbit/s) 8 kB blocks: 101630.3 IO/s, 832.6 MB/s ( 6.7 Gbit/s) 16 kB blocks: 55800.0 IO/s, 914.2 MB/s ( 7.3 Gbit/s) 32 kB blocks: 53508.0 IO/s, 1.8 GB/s ( 14.0 Gbit/s) 65 kB blocks: 27402.2 IO/s, 1.8 GB/s ( 14.4 Gbit/s) 131 kB blocks: 13882.6 IO/s, 1.8 GB/s ( 14.6 Gbit/s) 262 kB blocks: 7093.4 IO/s, 1.9 GB/s ( 14.9 Gbit/s) 524 kB blocks: 3702.2 IO/s, 1.9 GB/s ( 15.5 Gbit/s) 1 MB blocks: 2311.2 IO/s, 2.4 GB/s ( 19.4 Gbit/s) 2 MB blocks: 1389.0 IO/s, 2.9 GB/s ( 23.3 Gbit/s) 4 MB blocks: 774.4 IO/s, 3.2 GB/s ( 26.0 Gbit/s) 8 MB blocks: 411.8 IO/s, 3.5 GB/s ( 27.6 Gbit/s) 16 MB blocks: 212.8 IO/s, 3.6 GB/s ( 28.6 Gbit/s) 33 MB blocks: 107.6 IO/s, 3.6 GB/s ( 28.9 Gbit/s) 67 MB blocks: 54.7 IO/s, 3.7 GB/s ( 29.4 Gbit/s) 134 MB blocks: 27.5 IO/s, 3.7 GB/s ( 29.5 Gbit/s) 268 MB blocks: 13.8 IO/s, 3.7 GB/s ( 29.6 Gbit/s) 536 MB blocks: 6.9 IO/s, 3.7 GB/s ( 29.6 Gbit/s) 1 GB blocks: 3.5 IO/s, 3.8 GB/s ( 30.3 Gbit/s) 2 GB blocks: 1.6 IO/s, 3.5 GB/s ( 27.8 Gbit/s) Abchliessend das Raid 1 daraus: /dev/md2, 3.84 T, sectorsize=512B, #threads=10, pattern=random: 512 B blocks: 174184.8 IO/s, 89.2 MB/s (713.5 Mbit/s) 1 kB blocks: 157651.4 IO/s, 161.4 MB/s ( 1.3 Gbit/s) 2 kB blocks: 174565.3 IO/s, 357.5 MB/s ( 2.9 Gbit/s) 4 kB blocks: 188842.4 IO/s, 773.5 MB/s ( 6.2 Gbit/s) 8 kB blocks: 117564.7 IO/s, 963.1 MB/s ( 7.7 Gbit/s) 16 kB blocks: 63231.7 IO/s, 1.0 GB/s ( 8.3 Gbit/s) 32 kB blocks: 72580.9 IO/s, 2.4 GB/s ( 19.0 Gbit/s) 65 kB blocks: 37733.7 IO/s, 2.5 GB/s ( 19.8 Gbit/s) 131 kB blocks: 19708.6 IO/s, 2.6 GB/s ( 20.7 Gbit/s) 262 kB blocks: 11635.9 IO/s, 3.1 GB/s ( 24.4 Gbit/s) 524 kB blocks: 5206.0 IO/s, 2.7 GB/s ( 21.8 Gbit/s) 1 MB blocks: 4607.9 IO/s, 4.8 GB/s ( 38.7 Gbit/s) 2 MB blocks: 2725.1 IO/s, 5.7 GB/s ( 45.7 Gbit/s) 4 MB blocks: 1219.2 IO/s, 5.1 GB/s ( 40.9 Gbit/s) 8 MB blocks: 642.1 IO/s, 5.4 GB/s ( 43.1 Gbit/s) 16 MB blocks: 318.4 IO/s, 5.3 GB/s ( 42.7 Gbit/s) 33 MB blocks: 162.9 IO/s, 5.5 GB/s ( 43.7 Gbit/s) 67 MB blocks: 77.4 IO/s, 5.2 GB/s ( 41.6 Gbit/s) 134 MB blocks: 39.7 IO/s, 5.3 GB/s ( 42.6 Gbit/s) 268 MB blocks: 20.1 IO/s, 5.4 GB/s ( 43.1 Gbit/s) 536 MB blocks: 9.8 IO/s, 5.2 GB/s ( 42.0 Gbit/s) 1 GB blocks: 4.8 IO/s, 5.2 GB/s ( 41.5 Gbit/s) 2 GB blocks: 1.9 IO/s, 4.1 GB/s ( 33.1 Gbit/s)

Erstmal schien alles i.o. zu sein. Oder? Die Zahlen sprechen für sich. Also wollte ich lokal aus dem LVM Verbund sys und data eine eigene Partition und Filesystem anlegen und weitere Tests mit dd durchführen.

Mit den NVME Disks lief alles, wie man es erwartet. Partition angelegt mit Yast und Filesystem xfs mit Mountpoint /DATA eingerichtet. In wenigen Sekunden erledigt. Danach per dd if=/dev/zero of=/DATA/test.dmp bs=1G count=300 geprüft, was hier so durch geht. Mit durchschnittlich 2,1 GB/s wurde die Datei angelegt. Das hatte ich soweit auch erwartet.

Das gleiche nun mit dem Raid 10 aus SATA Platten:

Ich hatte den gleichen Effekt, wie bei der Installation. Es passierte zunächst nichts, 2-4 Cores waren mit 100% iowait beschäftig. Offensichtlich gibt es ein Problem mit den SATA Platten, siehe oben nein die sind wie erwartet schnell…

Ich wollte den Test wiederholen und machte einen nicht unwesentlichen unterschied. Ich legte die oben bereits erwähnte Partition zum testen mit dem Filesystem ext4 statt xfs an. Es dauerte für eine 512 GB trotzdem lang, aber es waren 1-2 Minuten statt der vorherigen 30-40 Minuten oder mehr bei einem xfs Filesystem.

Sollte etwas die Kombination aus Raid10 und LVM das Problem sein? Schlieslich wars im Raid 1 mit den NVME Disks entspannt… und normal schnell.

Neunstallation

Neues Versuch, Neues Glück. Neue Problem..

STRG + ALT + ENTF zeigte keine Wirkung Hardware Reset musste ausgelöst werden. Der 2. Anlauf war erfolgreich.

Der Plan diesmal:

Aus den 4 SATA Platten werden 2 * im Raid 1 ein Verbund erstellt und diese beiden md1 und md2 devices in LVM zusammen gefügt. Wie folgt:

Die Idee war gut, das Ergebnis bleibt aber das Gleiche.

Ein Plan B muss her…

Zumindest der letzte Versuch für diesen Fall. Zurück zu Ursprungskonfiguration und das System neu einrichten (Raid 10 aus 4 Platten), dafür auf XFS als Dateisystem verzichten und ext4 wählen. Klappt ja mit xfs beim NVME Storage und hier wird es auch gebraucht.

Um auch jeden Einfluss zu entfernen, boote ich ins Rettungssystem und lösche die Sata Platten, zumindest partiell per dd.

dd if=/dev/zero of=/dev/sd[a-e] bs=1G count=10

Damit sind alle Raid und Partition – Informationen entfernt.

In der Vergangenheit kam es immer wieder zu Problemen, weil das Betriebsystem eine bestehende Raid Konfiguration entdeckt hat. Meist wurde diese Information per Yast / mdadm etc. nicht zuverlässig entfernt. Somit lösche ich auf diesem Weg zuverlässig alle Hinterlassenschaften. Ein Neustart ist danach notwendig.

Installation läuft, stockt wieder beim Einrichten der Festplatten (20 min) aber nicht so lange, als xfs mit im Spiel war.

Mehrere Testvorgänge später kommt die ernüchternde Erkenntnis:

openSUSE 15.3 mit Stand vom 28.11.2021 kommt mit den 1 TB SATA Festplatten nicht zurecht. Partitionnierung oder das Anlegen und Löschen der LVM logical Volumes funktioniert erwartungsgemäss schnell. Beim Anlegen eines Dateisystems auf einem bestehen LVM, kommt es abhängig vom gewünschten Dateisystem, zu erheblichen Laufzeiten und die Festplatten sowie weitere Partitionen frieren u.U. ein.

256 GB war das zu testende Logical Volume definiert.

Bei XFS waren Laufzeiten von mehreren Minuten (20-30 min oder mehr*) bei der Anlage des Dateisystems zu messen.

time mkfs.xfs /dev/sys/test -f

meta-data=/dev/sys/test isize=512 agcount=16, agsize=4194288 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=1, sparse=0, rmapbt=0

= reflink=0

data = bsize=4096 blocks=67108608, imaxpct=25

= sunit=16 swidth=32 blks

naming =version 2 bsize=4096 ascii-ci=0, ftype=1

log =Internes Protokoll bsize=4096 blocks=32768, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =keine extsz=4096 blocks=0, rtextents=0

real 59m2,688s

user 0m0,000s

sys 0m5,708s

Beim Anlegen von ext4, als Gegenbeispiel, dauerte es ca. 5 Minuten. In beiden Fällen mit einer CPU Auslastung von 100% iowait bei 4 Cores / Threads. In beiden Fällen dauert es zu lang.

Fortsetzung folgt: Ein Ersatzsystem mit ausschliesslichen NVME Festplatten wird bestellt.

*Ich ab dann angefangen meine Wäsche zu waschen, zu bügeln… 😉 Also nicht ganz genau gemessen.